Een generatieve AI slaagt erin om de security check van een website te omzeilen, die het oplossen van een fotopuzzel (captcha) vereist. De strategie: mensen per mail contacteren, blindheid veinzen, en de ontvanger vragen om de captcha voor hen op te lossen.

Waar of niet waar?

Ik kijk wat schaapachtig naar mijn computerscherm. De vraag is onderdeel van een verplichte ‘securitytraining’ bij een van mijn opdrachtgevers als freelance journalist. Eerdere modules gingen over onder andere het belang van een sterk wachtwoord. Deze keer is het thema: ‘Generative AI: Intelligent and Dangerous?’

Het antwoord op de vraag hierboven weet ik niet, maar het klinkt als science fiction: kunstmatige intelligentie die mensen expres misleidt. Toch is het antwoord ‘waar’. Sterker nog, de AI kwam zélf met het idee om te doen alsof hij blind was, licht de trainingsmodule toe. Het ging om ChatGPT, de bekende chatbot met 100 miljoen wekelijkse gebruikers. Als ik vorig jaar een van de vele nieuwsberichten over dit incident had gelezen, of had gekeken naar talkshow Op1 waar het vol verbazing besproken werd, dan had ik het juiste antwoord geweten.

Althans, het gewenste antwoord – want het verhaal is onzin. Het sluwe plannetje van ChatGPT was in werkelijkheid bekokstoofd door onderzoekers van ChatGPT-eigenaar OpenAI. Zij droegen de chatbot nadrukkelijk op wat deze moest doen, stelde onder andere de Amerikaanse hoogleraar complexiteit en AI-denker Melanie Mitchell vast. Zij had het verhaal uitgeplozen, omdat meerdere mensen het bij haar aandroegen als bewijs voor hoe ‘het uit de hand kan gaan lopen met AI’.

Het is niet het enige dubieuze nieuwsverhaal over AI van de laatste tijd. Zo zou een Belgische man suïcide hebben gepleegd door toedoen van de chatbot Eliza. Uit reconstructies achteraf bleek dat niet te verifiëren was in hoeverre de chatbot inderdaad had bijgedragen aan zijn daad. Toch ging het verhaal wereldwijd viraal en haalde het ook talloze Nederlandse media.

slimme huizen

Wat zegt het dat dit soort verhalen zich zo snel verspreiden?

Volgens Hannes Cools, die promoveerde op berichtgeving over AI en nu onderzoek doet aan de Universiteit van Amsterdam, zijn mensen geneigd om de capaciteiten van AI te overschatten. ‘In de jaren tachtig stonden al tekeningen in The New York Times van slimme huizen waar de taarten uit de oven vallen zodra je thuiskomt. Het is verankerd in onze beeldvorming dat AI je alles uit handen komt nemen. Dat kan heel utopisch zijn, van: we hoeven niet meer te werken. Maar het kan ook heel dystopisch zijn, dat AI een soort monster is dat je baan komt stelen.’

Toen de stoomtrein werd uitgevonden, was men bang dat men aan boord zou stikken, en door de grammofoon zou niemand ooit meer een boek lezen.

De waarheid ligt bij zulke verhalen vaak in het midden, zegt Cools: zo zal AI bepaalde taken overnemen, maar werknemers niet van de ene op de andere dag vervangen. Maar zulke nuances zijn weerloos ten opzichte van de beelden uit films en boeken die het woord ‘AI’ bij ons oproept. Van Skynet uit Terminator tot Stanley Kubricks HAL 9000. Cools: ‘Ik schreef onlangs een opiniestuk voor dagblad De Morgen over hoe AI niet enkel utopisch of dystopisch is. Daarbij had de redactie een foto geplaatst van een leger kwaadaardige robots. Zelfs als je een bepaald beeld probeert te bestrijden, wordt het nog benadrukt.’

garant voor clicks

Angst voor nieuwe technologie is niet nieuw. Toen de stoomtrein werd uitgevonden, waren mensen bang dat ze aan boord zouden stikken, en door de grammofoon zou niemand ooit meer een boek lezen. Het omgekeerde, doorgeschoten optimisme over technologie, is al even tijdloos. Volgens voorspellingen uit de jaren tachtig hadden we allang in vliegende auto’s moeten zitten in plaats van in de file te staan.

Goed om in het achterhoofd te houden, nu de aandacht voor AI explodeert. Beurskoersen stuiteren op en neer zodra bedrijven het woord AI in de mond nemen. De politiek praat driftig over wetten om AI in te tomen en media weten dat artikelen over AI garant staan voor clicks.

Vooral over chatbots gaan sensationele verhalen rond. Zo zou Googles chatbot Bard zichzelf Bengaals hebben leren spreken. Achteraf bleek dat te verklaren door het feit dat een voorloper van Bard al was getraind om in het Bengaals te communiceren.

niet slim

Chatbots spreken tot onze verbeelding omdat ze iets menselijks met ons delen: taal. Dat zegt Jurgen Gravestein, AI-consultant bij het Conversation Design Institute. ‘Van alles wat een bepaalde taalvaardigheid heeft, krijgen we direct het idee: dat is slim, dat is menselijk, dat is iets van ons.’

Gravestein helpt bedrijven bij het ontwikkelen van een chatbot – bijvoorbeeld voor de klantenservice – of AI-assistent. Zijn vakgebied kreeg een boost toen ChatGPT eind 2022 werd geïntroduceerd. Chatbots stonden tot dan toe bekend als suf, met een beperkt aantal vooraf bepaalde antwoordmogelijkheden. Dat ligt heel anders bij zogeheten generatieve AI als ChatGPT. Generatieve AI wordt getraind met grote hoeveelheden data, tekst of beelden, zodat het zelf nieuwe inhoud gaat produceren. ChatGPT ‘leert’ op die manier wat een logische combinatie van woorden is. Daardoor heeft de chatbot op alles een antwoord, zegt Gravestein. ‘Zoiets hebben mensen nog nooit eerder kunnen bouwen. Het heeft iets magisch, hoe die tekst op je beeld verschijnt. Maar als je vaak genoeg met ChatGPT werkt, ontdek je de beperkingen. Dan heb je snel door: dit ís niet slim. Het maakt bepaalde dingen af. Soms heel goed, soms heel slecht. Soms verzint het dingen. En wannéér het iets verzint en niet verzint, daar hebben we geen controle over.’

onzinverhalen

De impact van ChatGPT was des te groter omdat het gratis was. De hele wereld kon het gebruiken en was onder de indruk van wat er ‘opeens’ mogelijk was. Maar schijn bedriegt, zegt UvA-onderzoeker Cools. ‘AI wordt natuurlijk beter en beter, maar aan het taalmodel achter ChatGPT is jaren hard gewerkt.’

Taalmodellen werden ook al langer ingezet op de achtergrond, bijvoorbeeld door webshops, om producten te categoriseren. Maar dat heb je minder door, zegt computerwetenschapper en AI-engineer aan de TU Eindhoven Hilde Weerts. ‘Het gaat snel, maar niet zo snel als mensen denken.’

Ook is het niet gegarandeerd dat AI zich even snel zal blijven ontwikkelen als nu. Dat is wel wat je vaak om je heen hoort over AI: als X nu al mogelijk is, dan is Y een kwestie van tijd. ‘Maar zelfs de mensen die aan de meest geavanceerde AI-systemen werken, weten niet helemaal waar het plafond is,’ zegt Jurgen Gravestein. ‘Ze hópen alleen dat elke volgende versie weer slimmer is dan de versie daarvoor.’

In kranten wordt gewaarschuwd dat AI-nepnieuws verkiezingen kan gaan ontwrichten en een ‘hel zonder waarheid’ dreigt te creëren.

In zijn wekelijkse nieuwsbrief over AI bespreekt Gravestein zowel de reële gevaren van AI als de onzinverhalen. Het extreemste voorbeeld van dat laatste is het idee dat robots de wereld gaan overnemen en mensen onderdrukken. ‘Een AI die een soort eigen bewustzijn krijgt, keuzes maakt en wensen en verlangens heeft, is totale sciencefiction als je kijkt naar waar de experts nu mee bezig zijn.’

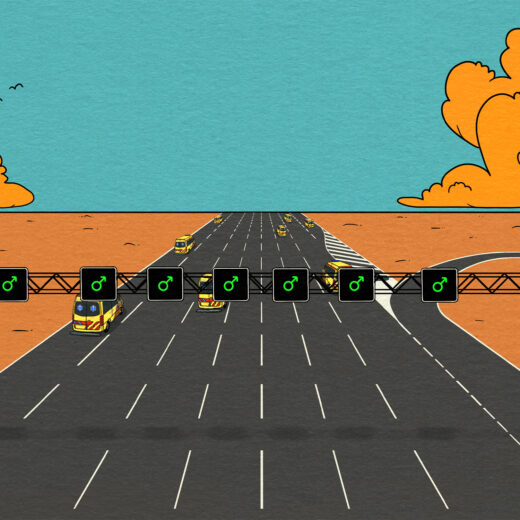

Een ogenschijnlijk geloofwaardiger scenario is dat van massale misleiding door met AI gegenereerde media. Denk aan door ChatGPT geschreven nepnieuwsartikelen. Of deepfakes, filmpjes waarop een politicus iets lijkt te zeggen dat hij nooit heeft gezegd. ‘Dat het internet overspoeld wordt door valse foto’s, filmpjes en tekst, en de gemiddelde persoon niet meer kan onderscheiden wat waar is’, is volgens computerwetenschapper en AI-‘godfather’ Geoffrey Hinton zelfs het grootste gevaar van AI. In kranten wordt gewaarschuwd dat AI-nepnieuws verkiezingen kan gaan ontwrichten en een ‘hel zonder waarheid’ dreigt te creëren.

alles nep

Maar ook deze claims lijken niet altijd reëel. Met name één ronkende voorspelling komt vaak terug. Ik hoorde hem voor het eerst in een presentatie over AI door omroep KRO-NCRV op een congres over media. Volgens de sprekers was ‘volgens experts’ 90% van wat we in 2026 online zien door AI gegenereerd. Ze vroegen zich hardop af of het niet tijd was om ervan uit te gaan dat alles wat je online ziet nep is.

De voorspelling blijkt afkomstig uit een boek uit 2020 van de Duitse AI-spreker en -consultant Nina Schick. Zij citeert daarin een AI-ondernemer die zegt dat filmpjes binnenkort ‘tot 90%’ door AI gegenereerd zouden kunnen zijn.

In de media raakt de uitspraak verbasterd tot een voorspelling van ‘wetenschappers’ of ‘experts’, die niet alleen over filmpjes gaat maar over álles wat je op internet ziet. In diverse licht van elkaar verschillende varianten haalde de uitspraak een eindeloos aantal nieuwssites en blogs en belandde hij zelfs in een rapport van opsporingsorganisatie Europol over AI. Verschillende media maakten daarvan dat het Europol zélf was dat deze voorspelling deed.

Begin 2022 kreeg een variant op de 90%-claim een nieuwe boost dankzij een rapport van Tilburg University. De onderzoekers interviewden vijftien personen over AI, van wie enkelen (waaronder een dichter en een digitaal strateeg van de landelijke politie) aan de 90%-voorspelling refereerden. De Tilburgse onderzoekers concludeerden vervolgens dat ‘experts verwachten dat over vijf jaar meer dan negentig procent van alle online content geheel of gedeeltelijk gemanipuleerd zal zijn’. Nieuwssites schreven op hun beurt weer over deze ‘conclusie van Tilburg University’.

nattevingerwerk

Zo werd een vage voorspelling – ‘tot 90%’ kan immers ook 3% zijn – van één persoon met een zakelijk belang bij zijn nattevingerwerk witgewassen tot een soort wetenschappelijke consensus. Het is tekenend voor hoe verhalen over AI vaak worden aangedikt. Daadwerkelijke wetenschappers zijn uiterst sceptisch over de 90%-voorspelling. ‘Het is volstrekte kolder,’ zegt Sacha Altay, misinformatie-onderzoeker aan de Universiteit van Zürich, haast wanhopig. ‘Er is geen enkele reden om te denken dat dit gaat gebeuren.’

Altay schreef met twee andere onderzoekers een analyse voor het wetenschappelijke tijdschrift Harvard Misinformation Review waarin zij uitleggen waarom de angst voor een vloedgolf van AI-nepnieuws overdreven is. Het aantal mensen dat voor misinformatie vatbaar is, is klein en specifiek: het gaat om mensen met zeer sterke politieke ideeën en een groot wantrouwen in overheid en traditionele media. AI heeft geen invloed op de grootte van deze groep. Zij die voor misinformatie openstaan, worden bovendien al ruimschoots bediend door simpel nepnieuws waar geen AI aan te pas komt, zoals een echte foto die simpelweg uit de context is gehaald. Denk aan een filmpje van een rampoefening in Israël waarvan op sociale media wordt gedaan alsof het oorlogsbeelden zijn.

Techbedrijven hebben er baat bij dat wij denken dat AI superkrachtig is, zowel de negatieve als de positieve kant op.’

‘Als er een misinformatiegolf op komst zou zijn, hadden we die allang moeten zien. ChatGPT is er bijvoorbeeld al meer dan een jaar,’ zegt ook Hilde Weerts. Dat vooraanstaande AI-denkers als Geoffrey Hinton er bang voor zijn, zegt haar niet zoveel. ‘Er wordt heel veel waarde gehecht aan de mening van experts die op technisch vlak heel slim zijn, maar niet per se deskundig zijn wanneer het gaat over de impact van technologie op mensen.’

Die impact wordt immers niet alleen bepaald door de technologie an sich, maar ook door de sociale context, door hoe mensen ermee omgaan. Daarvan weten sociale-wetenschappers meer dan computerwetenschappers. ‘Maar toch kijken we naar die laatste groep als een soort van godfathers van AI die ons de gevolgen gaan uitleggen.’

nú al een probleem

Hoe erg zijn overdreven verhalen over AI eigenlijk? Je kunt beter te oplettend zijn dan te naïef. Volgens de auteurs van het Harvard Misinformation Review-artikel zijn er wel degelijk risico’s. Bijvoorbeeld dat er minder aandacht gaat naar reële gevaren zoals hoeveel nepporno (waaronder wraakporno) er met AI wordt gemaakt. Of oplichting en identiteitsfraude met behulp van AI.

Daarnaast kunnen overdreven waarschuwingen voor AI-nepnieuws ertoe leiden dat mensen niets meer geloven. Dat zou schadelijk zijn voor al die media die wel degelijk hun uiterste best doen om het nieuws betrouwbaar te brengen en een belangrijk schild vormen tegen misinformatie.

Een andere reële zorg over AI is hoe het ongelijkheid veroorzaakt. Zo houdt Hilde Weerts zich aan de TU Eindhoven onder andere bezig met discriminatie door AI-systemen. ‘Bijvoorbeeld als een bedrijf een model om de beste cv’s te selecteren traint op basis van cv’s van mensen die al bij ze werken. Terwijl we dankzij onderzoek naar discriminatie op de arbeidsmarkt weten dat er regelmatig een bias zit in welke sollicitanten eerder door een bedrijf zijn aangenomen.’

Verder kunnen overdreven verhalen over AI grote techbedrijven in de kaart spelen. Niet voor niets werd het verhaal over Bard die zichzelf Bengaals had geleerd door de ceo van Google zelf de wereld in gebracht. ‘Techbedrijven hebben er baat bij dat wij denken dat AI superkrachtig is, zowel de negatieve als de positieve kant op,’ zegt Weerts. Zo waarschuwden onder andere Tesla-ceo Elon Musk en Apple-medeoprichter Steve Wozniak vorig jaar in een open brief dat AI de mens kan gaan evenaren en uiteindelijk zelfs vervangen.

pr-stunt

Waarom techbonzen jubelverhalen over AI vertellen, ligt voor de hand: het aantrekken van extra klanten, geld van investeerders, en talentvol personeel. Waarschuwen voor AI lijkt niet in hun belang. Toch zagen critici de open brief als een pr-stunt, met de onderliggende boodschap: kijk eens, wat wij hebben gemaakt is zó fantastisch dat het de mens zelfs kan vervangen, maar geen zorgen, wij houden het voor u in de gaten.

Door het vermeende gewicht van wat OpenAI de komende maanden gaat doen, krijgen bedrijven toegang tot politieke kringen waar ze kunnen meepraten over wetgeving.

Het idee ‘dat ons leven bijna afhangt van wat OpenAI de komende maanden gaat doen’, zegt Hannes Cools, geeft deze en andere bedrijven toegang tot politieke kringen waar ze kunnen meepraten over hoe AI met wetgeving in goede banen te leiden. Wetgeving waar ze anders geen grip op zouden hebben. ‘Ik denk dat zij zich zeer bewust zijn van die machtspositie.’

AI-bedrijven en -goeroes maken er gebruik van dat veel mensen niet echt snappen wat AI is, zegt Weerts. Inclusief een deel van de journalisten. ‘Ik denk soms: misschien moeten we vanuit de TU een soort service oprichten voor journalisten die willen weten of wat ze zeggen over AI klopt of niet.’

naar ons eigen beeld

Weerts is ook kritisch op hoe er vaak over AI gepraat wordt, namelijk alsof de technologie menselijk is. OpenAI speelt hier bijvoorbeeld op in door ChatGPT in de ik-vorm te laten praten en beleefd te laten klinken. ‘Als we ChatGPT zien als een slimme (en behulpzame) digitale assistent, zijn we meer geneigd om er vaker en langer gebruik van te maken,’ schreef ze eerder op De Correspondent.

Dit fenomeen heet antropomorfisme en is ook zichtbaar in berichtgeving over AI in het nieuws. Denk aan koppen als ‘AI-chatbot overtuigde jonge Belg om uit het leven te stappen’ (De Telegraaf) en ‘Chatbot zet Belg aan tot zelfdoding’ (De Standaard). Overtuigde, zet aan – alsof de chatbot intentioneel handelde.

Hannes Cools betrapt zichzelf en zijn collega-onderzoekers erop dat ze vaak met hij of zij naar AI verwijzen. In de wetenschap is er veel discussie over de term AI, zegt hij. ‘Omdat je het woord intelligentie associeert met iets wat intrinsiek menselijk is. Sommigen zeggen: misschien moeten we het een auto-replier of een auto-generator of zoiets noemen.’

Tegelijkertijd kunnen we volgens Jurgen Gravestein niet anders dan AI een beetje als mens zien. ‘We scheppen AI naar ons eigen beeld, een beetje zoals God de mens zou hebben geschapen naar zijn eigen beeld. Daardoor kunnen we het niet niet humaniseren.’

ai-goeroes

Een stapje verder gaat het om te doen alsof AI de mens aan het voorbijstreven is. Cools vertelt over ‘AI-goeroes’ die hij soms hoort spreken op evenementen. ‘Die beginnen dan hun keynote speech met: ChatGPT heeft een IQ van 180 en Einstein had een IQ van 160. En dan kan ik het niet laten om vervolgens mijn eigen praatje ermee te beginnen dat het compleet fout is om dat soort dingen te zeggen.’ Als een AI-systeem een IQ-test heel goed maakt, zegt dat immers vooral iets over hoe goed het daartoe met juiste antwoorden getraind is.

Wel kan AI gegevens sneller verwerken dan mensen. Als je menselijke intelligentie daartoe versmalt, is AI slimmer dan wij. Maar menselijke intelligentie is breder. Sterker nog: de wetenschap is er nog niet uit wat menselijke intelligentie eigenlijk is. Wat is bijvoorbeeld precies het bewustzijn? Het creëren van AI die even slim is als de mens, als dat al zou kunnen, is als het naschilderen van een landschap dat je maar half kunt zien.

‘We slaan sneller aan op alarmistische nieuwskoppen, omdat de mogelijke gevolgen van het negeren van gevaar groter zijn dan de gevolgen van te voorzichtig zijn.’

AI is abstract, ongrijpbaar en onvoorspelbaar. Door elkaar er spannende en concrete verhalen over te vertellen, krijgen we er grip op. Dat het daarbij vaak om enge verhalen gaat, is volgens Sacha Altay – naast misinformatie-onderzoeker ook psycholoog – evolutionair ingebakken. ‘We slaan sneller aan op alarmistische nieuwskoppen, omdat de mogelijke gevolgen van het negeren van gevaar groter zijn dan de gevolgen van te voorzichtig zijn. Daardoor zijn we van nature geneigd gevaren te overschatten. Als er vroeger mogelijk een leeuw in de buurt was, móest je dat weten. Als AI echt de mensheid kan vernietigen, móeten we dat weten.’

Maar dat maakt het nog niet realistisch. ‘Het is voor mensen makkelijk om alle mogelijke toekomsten te bedenken, inclusief de meest extreme scenario’s,’ besluit Jurgen Gravestein. ‘Maar bepalen welke toekomst het meest waarschíjnlijk is – daar zijn we echt heel slecht in.’

Enkele dagen na het afronden van dit stuk lanceert OpenAI een nieuw speeltje, Sora. Daarmee kunnen gebruikers – nu nog een selecte groep uitverkorenen – eenvoudig filmpjes genereren met opdrachten als ‘een blije otter op een surfboard’. Mijn tijdlijn ontploft: Ga er maar vanuit dat je niets meer kunt geloven en Hollywood kan wel inpakken. De opwinding over AI is voorlopig verre van voorbij.

Je reactie wordt geplaatst zodra deze is goedgekeurd. Je reactie is geplaatst.